科技日報記者 華凌

近日,北京前瞻人工智能安全與治理研究院、人工智能安全與超級對齊北京市重點實驗室、中國科學院自動化研究所人工智能倫理與治理中心聯合團隊正式發布靈御(PandaGuard)大模型安全攻防評估平臺。據悉,該平臺創新性地采用多智能體系統建模方法對越獄攻擊進行系統性評估。該框架在現有研究基礎上實現了重要突破,為構建安全可控的人工智能生態提供了重要保障。

不久前,在2025全球數字經濟大會數字安全主論壇暨2025北京網絡安全大會上,前瞻研究院院長、北京市重點實驗室主任曾毅受邀發表主旨演講,介紹靈御平臺及從人工智能安全到安全人工智能的發展戰略。

靈御(PandaGuard)平臺通過將大語言模型越獄安全概念化為多智能體系統來解決這些挑戰。在這個系統中,攻擊者、防御者、目標模型和安全判斷器相互作用。框架抽象并模塊化了每個組件,支持即插即用的實驗,包含19種攻擊算法、12種防御機制和多種判斷策略,對49個開源和閉源大語言模型安全性進行了系統化評估。靈御平臺的這種設計促進了可控的、可重現的評估,并使得能夠對模型安全中的跨組件權衡進行深度分析。

研究發現,不同時間發布的人工智能大模型并沒有隨著模型能力的提升而同時獲得模型的安全性,近期發布的國內外能力更強大的人工智能模型安全性并沒有展現出顯著的優勢。一些較新的模型在某些安全指標上可能不如早期版本,這揭示了一個重要事實:安全性能的提升需要專門的優化投入,而不是模型能力提高的自然副產品。我國的人工智能大模型安全性方面總體處于中等水平,特別是針對很多新近發布的大模型,針對越獄攻擊等方面的安全性上還有較大提升空間。北京前瞻人工智能安全與治理研究院院長曾毅說:現在國內外沒有一個絕對安全的人工智能大模型,但通過類似靈御平臺這樣的AI安全護欄加固,每一個大模型都可以做到更安全。

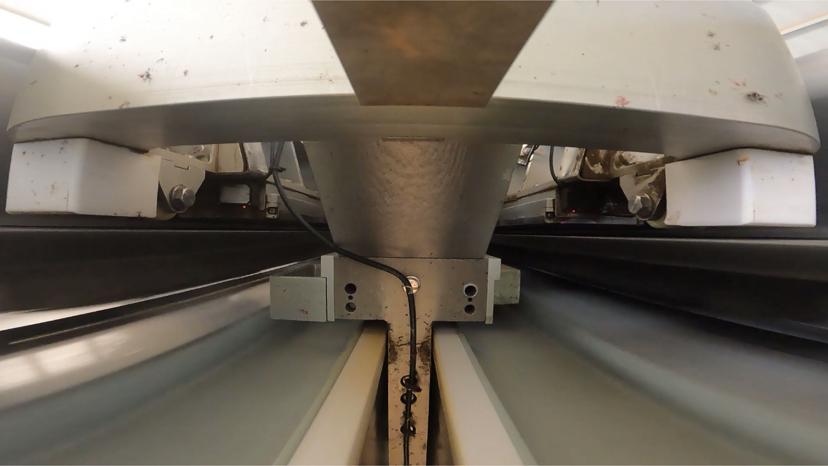

會上,曾毅總結道,安全與治理是人工智能核心能力,將加速人工智能穩健發展與應用。我們的前沿研究表明,如果把安全與模型能力比作魚與熊掌,實則可以兼得。沒有安全治理框架的人工智能不僅是沒有“剎車”,更是沒有“方向盤”。